幅広いメディアコンテンツ分野にAI技術を活用する、さまざまな研究が始まっています。

メディア学部 藤澤公也 講師

メディア学部では、メディアAI分科会を立ち上げ、メディアコンテンツにAIを活用する研究を進めています。今回は藤澤先生に、具体的な取り組みやご自身の研究についてお聞きしました。

■メディアAI分科会で取り組んでいる研究についてお聞かせください。

このプロジェクトは、メディア学部が扱うメディアコンテンツ分野を対象に、AI(人工知能)技術を適用して検証し、その可能性や課題を明らかにすることで、AI技術の革新に役立てようとスタートしました。メディア学部が扱うメディアコンテンツは、非常に幅広いのですが、今回は主にゲーム系と、私がずっと研究してきたソーシャルメディア系の研究を対象にしています。ただ、それ以外にも個々の先生方の研究分野に関連して、画像処理系や音声系などのAI研究も同時に進められています。

今、私が取り組んでいる研究では、ソーシャルメディアを用いた教育・授業支援にAIを活用するというものがあります。本学では大人数で受講する講義が減ってはいますが、それでも私が担当する1年生の必須科目には、300人が受講する講義があります。そういう大教室で、大勢の学生から質問などのフィードバックをもらうには、いくらメールなどのITを使ってもかなり時間を要します。それを解消しようと10年ほど前に、Twitterを使った仕組みを考えて導入しました。授業中、学生に質問をTwitterで投稿してもらい、それをプロジェクターで映しているパワーポイント上に表示させて、私が口頭で返答するというものです。これは、かなり良い結果が得られました。Twitterのような匿名性の高いものを使うと、質問するハードルが下がるので、学生も気軽に質問できますからね。それがTwitterを用いるメリットのひとつだと言えます。

一方で、その匿名性の高さが、別の問題を生みました。質問ではない、どうでもいいツイートが増えてくるんです。例えば感想だったり、単なるつぶやきであったり。ただ、それを禁止すると学生からのツイートが減る恐れもあるので、当初は思ったことをツイートしたい場合と質問の場合とで、ハッシュタグを分けていました。また、質問のハッシュタグを付けた場合は、パワーポイント画面に大きく表示され、そうでない場合は小さく画面下に出るという表示方法をとりました。この仕組みを5年以上続けてきたのですが、本来、取り上げたい質問が埋もれてしまい、逆に質問ではないものが大きく表示されるという課題が新たに発生しました。そこで、今年からAIに質問かそうでないかの分類をさせる試みをしています。AIが学生のツイート内容から、共有すべき質問だと判断したものは、大きく画面に映され、そうでないものは小さく画面に映されるのです。

これにはIBMのWatsonというAIの自然言語処理を使っていて、過去数年分の学生のツイートデータで学習させています。その学習によって、学生のツイートが共有すべき質問か、どうでもよい質問か、単なる感想かを自動で判断するということをしています。とはいえ、AIが勝手に分類するのではなく、あらかじめ過去のツイートに対して「これは質問、これは感想」と人間の手でタグ付けをしているんです。そこが大変なところです。実際、8年分あるデータの内、分類ができているのは、まだ2年分程度という状況ですから。そこをどうにかしようと、この分類自体もAIを使って自動化し、その分類が正しいかどうかを学生に評価してもらう仕組みをつくろうと考えています。

他にも、同じくIBMのWatsonを使った研究で、メディア学部の過去の卒業論文のデータから、どの先生の研究室がどういう研究をしているかを把握し、学生が「こういう研究をしたい」と入力すると、「○○先生が詳しいですよ」とアドバイスをくれるウェブページをつくっています。最初にも言いましたが、メディアコンテンツは非常に幅広い分野で、例えば“CG”といっても描きたいのか、ゲームに関係したことがしたいのか、その仕組みが知りたいのかで、研究室は変わってきます。そこで学生に合う研究室をうまく見つけられるように、研究テーマの検索システムを開発しました。また、ソーシャルメディアではありませんが、最近、取り組んでいるAI関連の研究もあります。

■それはどのような研究ですか?

カーネギー・メロン大学でつくられた「OpenPose」というソフトウェアがあります。これは画像や動画からAI技術を用いて人の骨格を抽出できるというもので、それを使って喫煙者を自動的に検知する研究を、本学部の太田高志先生と共同で進めているところです。この研究は、もともと太田先生がマイクロソフトのKinectを使って取り組んでいた研究で、喫煙者を検知すると、デジタルサイネージに咳込む人が映し出され、「タバコを吸わないで」というメッセージが流れるという仕組みを開発されていました。ただ、Kinectは最初にキャリブレーション(調整)した人しか検知できないという問題があり、実用性という点で難しい所がありました。

一方、「OpenPose」は、複数の人を誰でも同時に対象にすることができます。そこで今は、私や学生が喫煙しているポーズをとって、それをデータとして集め、どのくらいの精度で実際にタバコを吸っている人間を検知できるか調査しているところです。もちろん、携帯電話を持って話すといった似たような仕草を誤検知することもありますが、それも含めて検知の精度を上げる方法を探っているところです。

■先生の研究室では、どんなことに取り組んでいるのですか?

テーマとしては、AI、地図を使ったサービス(地図メディア)、モバイルメディアの3つを挙げています。そのうちのAIに関する研究が、これまでお話ししてきたもので、今年からスタートしたものです。私自身はもともとニューラルネットワークといったAIに関連する研究をしていましたが、本学に赴任した頃は、今のような第三次AIブームが来る前だったので、AI研究からは離れて、地図メディアやモバイルメディアの研究をしてきました。

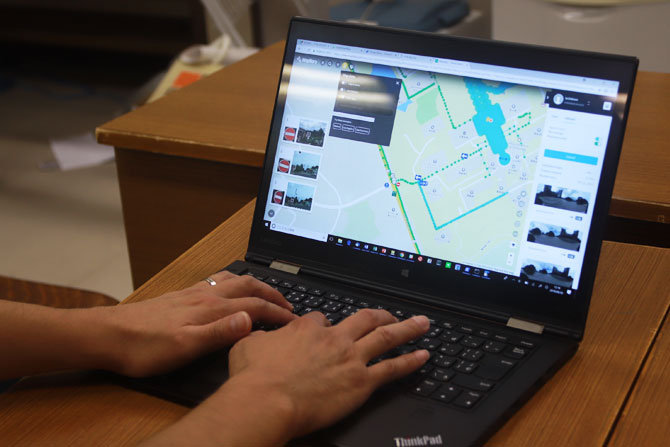

地図メディアの研究に関しては、2004年にイギリスで始まった「OpenStreetMap」(以下OSM)というプロジェクトがあり、それを使った研究をしています。OSMはウィキペディアのように一般ユーザーが自由に書き込める仕組みになっていて、地図を書いた人の著作権はあるが、それを行使しないというルールになっています。つまり、誰でも自由に地図を使える仕組みになっているのです。余談ですが、少し前に話題になったスマートフォンゲームの「ポケモンGO」に使われている地図データもOSMです。

このOSMのデータをどう使うかということと、効率よくデータを入力するための方法という2つの方向で研究をしています。例えば、過去には学生がキャンパスの建物の高さを測って、手動でデータを入力したり、航空写真から松の木や街灯などを一本一本地図に入力したりして、OSM上に表示される本学を3D画像として見られるように取り組みました。また、現在、OSMでは経路探索機能として歩行者、自転車、自動車を調べられるのですが、それに加えて車イスやベビーカーの経路探索ができないかと研究しています。

モバイルメディアの研究に関しては、新しい技術が次々と出てくるので、それらを使って、何か面白いことをしようと取り組んでいます。これまでの研究例としては、今年の3月でサポートが終了しましたが、Googleの開発したAndroid向けAR(拡張現実)技術「Tango」を使った研究がありました。学生がこの技術を使って、自分の見たい情報だけを選別して見られる学内掲示板システムをつくることに取り組みました。

■今後の展望をお聞かせください。

今日お話しした研究を融合させたようなことができると、面白いのではないかと思っています。例えば、地図メディアとAIを組み合わせて、地図のデザインを自動化できないかと考えています。単純に地図の見た目を変えようとすると、道の太さや色などデザインすべき要素がたくさんあるんですね。そこを上手くAI技術を使って、色んな地図のデザインデータを集めて学ばせて、例えばシックな感じの地図をつくりたいとか、デフォルメした地図をつくりたいと、文章による説明を用いて、AIがデザインを決めるというものができないかと思っています。

例えば、主要な駅名やランドマークと道路だけをシンプルに配置すると、デフォルメされた地図になります。そこにAI技術を用いると、詳しい地図データからポイントとなるものを自動で抽出して、自動的にデフォルメした地図の生成ができるのではないかと考えています。

■最後に受験生・高校生にメッセージをお願いします。

皆さんの中にもAIに興味を持っている方がたくさんいると思います。AIそのものを研究したい人は、本学の場合、コンピュータサイエンス学部がありますが、その中でもメディアコンテンツに関わるAIを学びたいならメディア学部が最適です。ぜひ一緒に研究しましょう!

■メディア学部WEB:

https://www.teu.ac.jp/gakubu/media/index.html

・次回は10月26日に配信予定です